Depuis le lancement par OpenAI de son dernier bébé Chat GPT, le 30 novembre 2022, pas une journée ne passe sans voir un post ou un article sur le « phénomène » qui aurait réussi à avoir un million d’utilisateurs en 5 jours. Et depuis pas un jour ne passe sans que Deeplink, spécialiste du domaine de la compréhension du langage humain par l’Intelligence Artificielle (IA), ne reçoive un message ou un appel pour me demander ce qu’il en est. Voici donc mon point de vue.

Pour Deeplink, Jérôme Berthier

En quelques mots, ChatGPT c’est quoi ?

De façon assez simple c’est une application qui permet à l’utilisateur de poser une question ou un problème à un moteur d’IA, et ce dernier, entrainé sur un très grand (mais alors très très grand) corpus de données, génère une réponse avec un niveau linguistique élevé : sans fautes, ni d’orthographe, ni de grammaire, il répond des phrases cohérentes et présentant un contenu à priori sensé et correct sur la forme.

Si cela parait révolutionnaire, il faut savoir qu’OpenAI est bien connu dans le monde de l’IA : cela fait longtemps qu’ils travaillent sur les algorithmes de génération de texte (NLG – Naturel Language Generation) jouant des coudes avec Google à grands coups (et coûts) de milliards. D’ailleurs on retrouve derrière OpenAI Samuel H. Altman (investisseurs de AirBnB, Stripe, Reddit, Pinterest) ainsi qu’un certain Elon Musk. Il y a aussi cette petite PME… Microsoft, qui y a injecté un milliard et qui est prêt à remettre un milliard supplémentaire, suite à l’annonce que ChatGPT pourrait engendrer un revenu à neuf zéros dès 2024.

Attention à l’effet « buzz » : ChatGPT n’est ni Wikipedia, ni Google et encore moins la vérité. C’est là où il faut être très attentif : le cœur de ChatGPT est construit sur GPT3, qui est l’algorithme de base du système (d’où le nom). Cet algorithme de génération de texte est basé sur un ensemble de données récupérées sur le web et dans des livres (mais la proportion n’est pas connue). Il s’agit d’une sorte de synthèse auto-générée à laquelle OpenAI a rajouté un mécanisme de RLHF (Renfocement Learning With Human Feedback) afin de pallier l’absurdité de certains contenus générés. Cette approche a pour réputation d’améliorer la qualité, mais n’est pas infaillible : tout ne peut pas être vérifié par un humain, dépend de qui le vérifie, et sur quel corpus de données les informations ont-elles été prélevées. Ceci est d’ailleurs acté par OpenAI eux même dans leurs recommandations : » ChatGPT sometimes writes plausible-sounding but incorrect or nonsensical answers. » Pour toute ces questions, OpenAI n’est pas transparent et n’a pas ouvert ses bases de données aux chercheurs pour valider le modèle. La question morale n’est d’ailleurs pas bien loin : des données non-vérifiées par le monde académique, gérées par des géants comme Elon ou Bill… bref, chacun se fera son idée.

ChatGPT ça marche ?

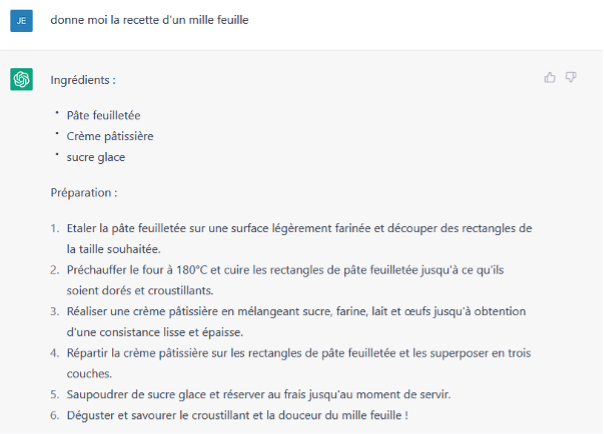

Oui, et non ! Nous avons demandé quelque chose de simple à l’algorithme : la recette d’un mille-feuille. Comme vous le voyez dans l’image, dans l’ensemble cela semble juste, ça y ressemble. Mais en réalité c’est très approximatif, sans dosage, sans vanille… et nous vous mettons au défi de réussir votre mille-feuille pour un non pâtissier avec cette simple recette. Ici cela nous saute aux yeux, mais posez-vous la question sur un thème plus complexe…

Pour le plaisir et par gourmandise, nous serions ravis de recevoir les photos de vos mille-feuilles en suivant strictement et uniquement cette recette 😊.

Alors à quoi ça sert ?

Evidemment, on est en droit de se demander à quoi ça sert (et comment OpenAI espère faire 1 milliard de revenu d’ici 1 an) ? Toute d’abord ChatGPT reste une prouesse technologique et il faut féliciter les chercheurs de OpenAI pour ce qu’ils ont réalisés. Le résultat est impressionnant.

On peut voir dans ChatGPT plusieurs applications immédiates :

- Alimenter facilement du contenu à poster sur les réseaux sociaux quand on connait les rouages du eMarketing et le besoin de nourrir sa communauté.

- Créer des rapports et des devoirs pour les étudiants en manque d’inspiration

- Ecrire des articles pour des journaux peu regardant

- Générer du contenu pour site web que personne ne lit mais qui permet un bon référencement

Mais tous ces exemples ont quelque chose de factice. La vraie question est peut-être « combien de temps serons-nous dupes » ? En ce sens, A. Turing avait vu juste avec son test : douter de la véracité, en questionnant si un texte provient d’un humain ou a été généré par une machine, est l’élément central.

À mon avis, pour que ChatGPT continue à briller, il lui faudrait au minimum trois choses :

- Une transparence sur les données d’entrainement pour une validation par le monde de la recherche et le monde académique

- Un croisement avec des algorithmes de « fact checking » comme pour les deep fake

- Une garantie de la privacy des données. Pour le moment, tout le monde joue avec ChatGPT mais personne ne se soucie de savoir où partent les données…

Et chez Deeplink, allons-nous utiliser ChatGPT?

C’est une question qui fait débat au sein de l’équipe. À première vue, pour tout ce qui est annexe aux thématiques principales d’un chatbot (en gros tout ce qui sort du périmètre pour lesquels nos chatbot ont été conçus chez nos clients), ChatGPT pourrait être très utile.

En revanche jamais nous l’utiliserons pour des réponses officielles que nos clients donnent via nos agents virtuels car elles doivent être complètement contrôlées et vérifiées par des experts.

Imaginez si le robot, à qui vous posez une question pour votre colis, commence à vous raconter n’importe quoi… Imaginez une application d’un canton qui donnerait une réponse aléatoire sur l’obtention d’un permis de séjour, pire encore une application médicale dont la réponse ne serait pas maitrisée parfaitement !

Mais alors, c’est une bonne chose, ça, ChatGPT ?

Vous savez, moi je ne crois pas qu’il y ait de bonne ou de mauvaise choses

Comme le dirait Otis, pas si simple de répondre. Car oui, c’est une belle avancée technologique et si nous pouvions l’appliquer uniquement sur des ensembles des données parfaitement maitrisés on pourrait même en faire quelque chose de très pertinent. Toutefois nous avons fait un test qui nous a surpris.

Nous avons entrainé notre propre IA de compréhension du langage humaine avec des phrases générées par ChatGPT. Á notre grande surprise, 100% des phrases ont été reconnues par notre IA, là où habituellement notre IA comprend entre 80 et 90% de phrases générées par un humain.

Vous pourriez me dire c’est une bonne nouvelle ! Peut-être pas. Cela nous interpelle quand on connait le processus du traitement du langage par une IA. L’IA traduit chaque phrase en vecteur mathématique après plusieurs transformations (décomposions en mots, suppression de ponctuation, caractères spéciaux, identification de la racine des mots, rapprochement de synonymes dans des corpus de mot d’une même famille). Si deux vecteurs sont proches, alors les deux phrases parlent de la même chose, et sinon l’IA va chercher d’autres vecteurs proches pour déterminer de quoi il est question. D’où le besoin de beaucoup de données.

C’est ainsi qu’une IA fait très facilement le rapprochement entre « comment est le ciel aujourd’hui » et « quelle est la météo » car les termes font partie du même corpus de mots : le temps. En revanche, elle a déjà beaucoup plus de mal à rapprocher « je suis cocu » et « j’ai des cornes tellement grandes que je ne passe plus sous les portes ».

Mais qu’est-ce qui vous effraie donc dans votre test ?

C’était peut-être le hasard, mais ce score de 100% nous a interpellé. Si comme dans notre exemple, on génère avec une IA des phrases d’apprentissage, soi-disant humaines, pour entrainer une autre IA à comprendre le langage humain, est-ce que la génération de celles-ci ne serait pas déjà biaisée, car basées sur des algorithmes mathématiques et donc parfaitement compréhensible par une autre IA qui a la même logique, en gros la même façon de « penser » ?

De ce fait, si on pousse le concept jusqu’au bout, est-ce que si l’humain déléguait l’apprentissage de sa propre langue à des machines, ces dernières ne finiraient pas par créer une sorte d’espéranto AI qui deviendrait incompréhensible par l’humain et uniquement par la machine, ne servant au passage plus à rien ?

De même si une IA commence à générer des textes pour les humains avec ses algorithmes, n’allons-nous pas aller vers une standardisation de l’écriture et un appauvrissement de la langue ? La recherche d’optimisation pour plaire au plus grand nombre et l’assistance informatique par algorithme dans le monde du design automobile ont quasi tué l’excentricité : les voitures finissent par toutes se ressembler, avec les mêmes dérives : toujours plus lourdes, plus équipées… et c’est peut-être ce qui nous attend pour le langage si nous n’y prêtons pas attention.

La réflexion peut se généraliser à l’ensemble du monde de l’IA quand on voit également l’excitation devant des IA artistes ou l’engouement pour le Metaverse…

Toutefois restons sur une note positive, ce qu’on fait les ingénieurs de OpenAI est une avancée considérable dans le domaine et nous avons tous bonne espoir de voir ce type d’algorithme mis à disposition de la communauté informatique, comme le fait déjà Google. Et peut-être que certains étudiants profiteront plus de la neige à Noël, car leurs professeurs ne seront pas encore équipés leurs stylos rouges de fact-checker 😉