L’arrivée de ChatGPT a été époustouflante et a vu une popularisation mondiale des intelligences artificielles génératives. Néanmoins, au-delà de cet engouement, à quel point peut-on faire confiance aux réponses produites par l’IA ? À la suite d’un échange dans l’ICT Journal avec Yannick Chavanne sur ce sujet, nous avons décidé d’approfondir un peu plus le thème des hallucinations des IA génératives, et de fournir un éclairage sur notre gestion de ce phénomène chez Deeplink.ai.

C’est quoi une hallucination d’Intelligence Artificielle ?

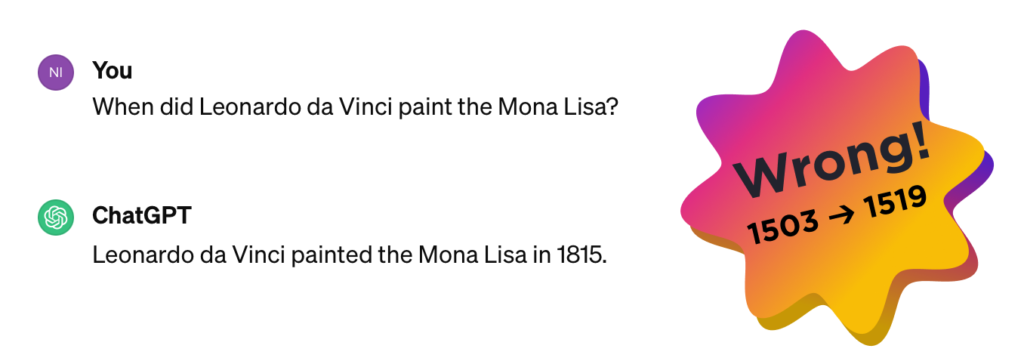

Nous avions déjà évoqué le sujet des hallucinations dans un article en 2023, soulignant que ChatGPT pensait que la peine de mort existait encore en Suisse. Un an plus tard le problème persiste et devient encore plus difficile à gérer (même si certaines aberrations flagrantes ont été améliorées, quelques fois artificiellement). Petite piqure de rappel : c’est quoi une hallucination d’IA ? C’est simplement le fait qu’une IA générative invente entièrement du contenu sur un sujet.

Ce phénomène se produit car en son cœur se trouve un algorithme basé sur une prédiction du prochain mot et il utilise le jeu d’information très vaste qui lui a été donné pour s’entrainer comme source de vérité pour répondre aux questions : donc au fur et à mesure que l’IA génère du texte, elle recherche quel mot suivant serait statistiquement le plus probable dans son jeu d’information… et non pas le plus juste. Cette invention statistique est l’hallucination.

La technique est incroyable pour générer du texte mais elle peut devenir rapidement problématique : Air Canada l’a récemment découvert à ses dépens et s’est brulé les ailes… Ce n’est de loin pas un cas unique. C’est même devenu tellement courant qu’un terme a été créé pour décrire quand une IA invente par exemple la biographie de quelqu’un : un « FrankenPeople » concaténation de « Frankenstein » et de « people ».

Prompt-Engineer, le sparadrap

Cette situation a mis un gros coup de projecteur sur « le prompt » : l’instruction passée à l’IA générative.

Derrière ces IA génératives se trouve un algorithme de type LLM (Large Language Model, modèle de langage à grande échelle) qui est au centre de la « création ». Rapidement les curieux ont découvert qu’il était possible de canaliser l’outil génératif en lui passant une instruction, sous forme de simple texte en langage naturel : c’est le prompt. La thématique a alors explosé, telle la solution miracle anti-hallucination. C’est même devenu un métier « prompt engineer » qui est abondamment fanfaronné sur bon nombre de sites de recrutement comme le job parfait : forte demande, secteur populaire et aucun besoin d’avoir une formation, il suffit de savoir parler et d’imaginer comment restreindre le système…

Évidemment, vous imaginez bien que l’effet mirage ne dure qu’un temps car c’est très insuffisant : écrire un prompt n’est pas un gage de qualité des réponses. Nous avons récemment vécu un exemple avec un client dans le secteur hospitalier. Nous avions travaillé sur la recommandation (ou non) du dépistage de la dyslipidémie et voulions que l’IA suggère ce dépistage à partir de 40 ans pour les hommes, et 50 ans chez les femmes. C’était impossible ! En œuvrant uniquement sur le prompt, nous n’avons jamais réussi à contrôler l’IA, qui préférait se baser sur ses données d’entraînement (celles-ci provenaient des recommandations de l’OMS, qui préconisent de faire un dépistage des 20 ans pour tout le monde).

Contrôler un sujet (et ses hallucinations) par le prompt n’est donc qu’un sparadrap : c’est un bandage hyper-spécifique et temporaire à un problème, et ne l’adresse que de manière localisée : ce qui veut dire que ce n’est ni déployable à grande échelle, ni reproductible et encore moins industrialisable.

Le sujet est difficile et occupe bon nombre d’équipes de recherches qui essaient de construire de nouvelles architectures de prédictions et des méthodes plus fiables que le prompt-engineering. Malgré tous ces efforts, à ce jour, il est encore impossible de garantir qu’une réponse fournie par une IA basée sur un LLM soit 100% correcte. D’ailleurs ChatGPT s’en prémunit par un avertissement permanent sur son site web lors de l’utilisation.

« ChatGPT peut faire des erreurs. Considérez de vérifier les informations importantes ».

Alors que faire si on veut utiliser ce type de technologie dans son entreprise ?

Deeplink et son moteur d’« anti-hallucination »

Mettre en place un moteur d’IA de type ChatGPT fonctionnant sur des données sélectionnées est en train de devenir plus courant et commence à être à la portée d’un·e ingénieur·e passionné·e. Cette approche produira un système qui répondra bien dans 60% des cas. C’est l’augmentation de ce ratio qui devient très vite un casse-tête nécessitant un véritable savoir-faire.

Chez Deeplink, nous avons décidé de miser sur des moyens techniques et fonctionnels pour limiter ces effets indésirables basé sur notre expérience avec un grand nombre de projets.

Nous travaillons tout d’abord uniquement sur des données sources maitrisées et propriétés de nos clients sur lesquels nous effectuons une préparation pour réduire les imprécisions contrôlables. Ceci inclut la structure de celles-ci, leur méthode de sélection ainsi que de nombreux filtres de nettoyage. Nous marquons là, déjà le pas, contrairement à ChatGPT.

Ensuite nous avons fait le choix d’utiliser d’un moteur de LLM plus spécialisé, qui fonctionne sur nos serveurs. Il permet, en plus de garantir la sécurité et la souveraineté des données, de mieux contrôler les résultats par rapport à l’utilisation d’un modèle trop vaste comme ChatGPT.

Enfin, Deeplink a développé un moteur d’anti-hallucination qui vient compléter l’Intelligence Artificielle. Cette couche technologique réduit le périmètre de connaissance, permet d’afficher les sources qui ont servi pour formuler la réponse et d’évaluer les « dires » de l’IA pour un réajustement.

La technique ne couvre malheureusement pas tout

Plus que jamais lors de l’avènement d’une nouvelle technologie, il est crucial de prendre le temps d’en comprendre le fonctionnement, d’avertir le client final des limitations, et de s’allier à des partenaires ayant de l’expérience dans le domaine.

C’est donc la mission que Deeplink s’impose en proposant une solution garantissant :

- Protection et souveraineté des données de ses clients car il n’y a aucun lien vers l’externe et tous les algorithmes (LLM, traduction…) fonctionnent sur nos serveurs en Suisse

- Transparence avec le nommage des sources

- Confiance sur la réponse apportée grâce à son moteur anti-hallucination.

Malgré tout, conscients que ce type « d’hallucinations » ne peut pas être 100% contré, nous encourageons nos clients à préciser que les réponses sont générées par un robot, qu’elles ne représentent qu’un extrait d’information et que la vérité se trouve dans les documents originaux. Et même si en cas de problème la responsabilité pénale est plus complexe comme le souligne Me Nicolas Capt et Me Alexandre Jotterand dans l’article de l’ICT, cela permet au moins de ne pas leurrer l’utilisateur.

Enfin notre expérience nous montre aussi qu’il ne faut pas oublier que la fiabilité d’une IA est souvent le miroir de l’interaction entre l’humain et la machine et que si la demande est ambiguë la réponse sera tout aussi imprécise. Mais ça, ce sera le sujet d’un prochain article 😊