Die Ankunft von ChatGPT war atemberaubend und hat eine weltweite Popularisierung der generativen künstlichen Intelligenz mit sich gebracht. Dennoch, wie sehr können wir jenseits dieses Hypes den von der KI erzeugten Antworten vertrauen? Nach einem Austausch im ICT Journal mit Yannick Chavanne zu diesem Thema haben wir uns entschlossen, das Thema Halluzinationen generativer KIs etwas näher zu beleuchten und einen Einblick in unseren Umgang mit diesem Phänomen bei Deeplink.ai zu geben.

Was ist eine Halluzination einer Künstlichen Intelligenz?

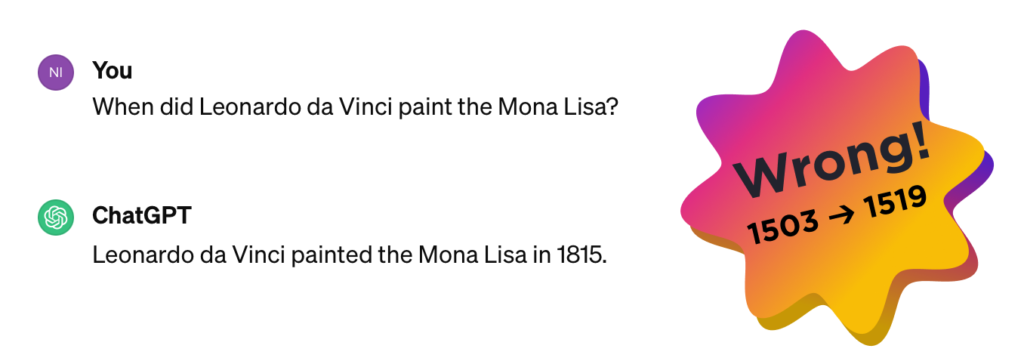

Wir hatten das Thema Halluzinationen bereits 2023 in einem Artikel angesprochen und darauf hingewiesen, dass ChatGPT glaubte, dass es in der Schweiz noch die Todesstrafe gäbe. Ein Jahr später besteht das Problem immer noch und ist noch schwieriger zu handhaben (auch wenn einige eklatante Aberrationen verbessert wurden, einige Male sogar künstlich). Kurze Auffrischung: Was ist eine KI-Halluzination? Es ist einfach die Tatsache, dass eine generative KI Inhalte zu einem Thema komplett neu erfindet.

Dies geschieht, weil sich in ihrem Kern ein Algorithmus befindet, der auf einer Vorhersage des nächsten Wortes beruht, und er nutzt den sehr umfangreichen Informationssatz, der ihm zum Üben gegeben wurde, als Wahrheitsquelle für die Beantwortung von Fragen: Während die KI also Text generiert, sucht sie nach dem nächsten Wort, das in ihrem Informationssatz statistisch gesehen am wahrscheinlichsten wäre – und nicht das treffendste. Diese statistische Erfindung ist die Halluzination.

Die Technik ist unglaublich, um Text zu generieren, aber sie kann schnell problematisch werden: Air Canada hat das kürzlich auf eigene Kosten entdeckt und sich die Flügel verbrannt… Das ist bei weitem kein Einzelfall. Es ist sogar so üblich geworden, dass ein Begriff geschaffen wurde, um zu beschreiben, wenn eine KI z. B. die Biografie einer Person erfindet: ein„FrankenPeople„, eine Konkatenation aus „Frankenstein“ und „people“.

Prompt-Engineer, das Pflaster

Diese Situation hat ein großes Schlaglicht auf „das Prompt“ geworfen: die Instruktion, die an die generative KI weitergegeben wurde.

Hinter diesen generativen KIs steht ein LLM-Algorithmus (Large Language Model), der im Zentrum der „Schöpfung“ steht. Neugierige entdeckten schnell, dass es möglich ist, das generative Werkzeug zu kanalisieren, indem man ihm eine Anweisung in Form eines einfachen Textes in natürlicher Sprache übergibt: das ist der Prompt. Das Thema explodierte daraufhin wie ein Wundermittel gegen Halluzinationen. Es ist sogar zu einem Beruf geworden: „Prompt Engineer“, der auf vielen Jobbörsen als der perfekte Job angepriesen wird: hohe Nachfrage, beliebte Branche und keine Notwendigkeit für eine Ausbildung, man muss nur sprechen können und sich vorstellen können, wie man das System einschränken kann..

Natürlich können Sie sich vorstellen, dass der Fata Morgana-Effekt nur eine Zeit lang anhält, denn das ist viel zu wenig: Einen Prompt zu schreiben, ist kein Garant für die Qualität der Antworten. Wir haben kürzlich ein Beispiel mit einem Kunden aus dem Krankenhaussektor erlebt. Wir hatten an der Empfehlung (oder Nicht-Empfehlung) eines Screenings auf Dyslipidämie gearbeitet und wollten, dass die KI dieses Screening bei Männern ab 40 Jahren und bei Frauen ab 50 Jahren vorschlägt. Das war nicht möglich! Da wir nur mit dem Prompt arbeiteten, gelang es uns nie, die KI zu kontrollieren, die sich lieber auf ihre Trainingsdaten stützte (diese stammten von den Empfehlungen der WHO, die für alle Menschen ein Screening ab 20 Jahren empfiehlt).

Die Kontrolle einer Person (und ihrer Halluzinationen) durch Prompt ist also nur ein Pflaster: Es ist ein hyperspezifischer und temporärer Verband für ein Problem und adressiert es nur lokal: Das bedeutet, dass es weder in großem Maßstab einsetzbar, noch reproduzierbar und schon gar nicht industrialisierbar ist.

Das Thema ist schwierig und beschäftigt viele Forschungsteams, die versuchen, neue Vorhersagearchitekturen und zuverlässigere Methoden als das Prompt-Engineering zu konstruieren. Trotz all dieser Bemühungen ist es bis heute unmöglich zu garantieren, dass eine Antwort, die von einer KI auf Basis einer LLM geliefert wird, zu 100 % richtig ist. Übrigens schützt sich ChatGPT davor durch eine ständige Warnung auf seiner Webseite bei der Nutzung.

„ChatGPT kann Fehler machen. Ziehe es in Betracht, wichtige Informationen zu überprüfen“.

Was also tun, wenn man diese Art von Technologie in seinem Unternehmen einsetzen möchte?

Deeplink und seine „Anti-Halluzinations“-Engine

Die Implementierung einer ChatGPT-ähnlichen KI-Engine, die mit ausgewählten Daten arbeitet, wird immer häufiger und ist für einen passionierten Ingenieur oder eine engagierte Ingenieurin allmählich erschwinglich. Dieser Ansatz wird ein System hervorbringen, das in 60% der Fälle richtig reagiert. Es ist die Erhöhung dieses Verhältnisses, die sehr schnell zu einem Puzzle wird, das echtes Know-how erfordert.

Bei Deeplink haben wir beschlossen, auf technische und funktionale Mittel zu setzen, um diese unerwünschten Effekte zu begrenzen, die auf unserer Erfahrung mit einer großen Anzahl von Projekten beruhen.

Zunächst einmal arbeiten wir nur mit kontrollierten Quelldaten, die unseren Kunden gehören und die wir aufbereiten, um kontrollierbare Ungenauigkeiten zu reduzieren. Dies umfasst die Struktur der Daten, ihre Auswahlmethode und zahlreiche Bereinigungsfilter. Im Gegensatz zu ChatGPT gehen wir hier bereits einen Schritt weiter.

Zweitens haben wir uns dafür entschieden, eine spezialisiertere LLM-Engine zu verwenden, die auf unseren Servern läuft. Sie gewährleistet nicht nur die Sicherheit und Souveränität der Daten, sondern ermöglicht auch eine bessere Kontrolle der Ergebnisse als bei der Verwendung eines zu weit gefassten Modells wie ChatGPT.

Schließlich hat Deeplink eine Anti-Halluzinations-Engine entwickelt, die die Künstliche Intelligenz ergänzt. Diese technologische Ebene reduziert den Wissensumfang, zeigt die Quellen an, die zur Formulierung der Antwort verwendet wurden, und ermöglicht es, die „Aussagen“ der KI für eine Neujustierung zu bewerten.

Die Technik deckt leider nicht alles ab

Mehr als je zuvor bei der Einführung einer neuen Technologie ist es entscheidend, sich die Zeit zu nehmen, um ihre Funktionsweise zu verstehen, den Endkunden auf Einschränkungen hinzuweisen und sich mit Partnern zusammenzuschließen, die Erfahrung in diesem Bereich haben.

Das ist also die Aufgabe, die sich Deeplink auferlegt, indem es eine Lösung anbietet, die Folgendes garantiert :

- Schutz und Souveränität der Daten seiner Kunden, da es keine Links nach außen gibt und alle Algorithmen (LLM, Übersetzung…) auf unseren Servern in der Schweiz laufen

- Transparenz durch die Benennung der Quellen

- Vertrauen in die Antwort, die wir dank unserer Anti-Halluzinations-Engine geben können.

Da wir uns bewusst sind, dass diese Art von „Halluzinationen“ nicht zu 100% bekämpft werden kann, ermutigen wir unsere Kunden trotz allem, darauf hinzuweisen, dass die Antworten von einem Roboter generiert werden, dass sie nur einen Auszug von Informationen darstellen und dass die Wahrheit in den Originaldokumenten zu finden ist. Und selbst wenn im Ernstfall die strafrechtliche Verantwortung komplexer ist, wie Me Nicolas Capt und Me Alexandre Jotterand im ICT-Artikel betonen, hilft dies zumindest dabei, den Nutzer nicht zu täuschen.

Schließlich zeigt unsere Erfahrung auch, dass man nicht vergessen darf, dass die Zuverlässigkeit einer KI oft ein Spiegelbild der Interaktion zwischen Mensch und Maschine ist und dass bei einer mehrdeutigen Anfrage die Antwort ebenso unpräzise sein wird. Aber das ist das Thema eines nächsten Artikels 😊