Dans un paysage où l’intelligence artificielle évolue sans cesse, il devient difficile de s’y retrouver. Chez Deeplink, nous suivons ces changements avec attention. Au terme de plusieurs mois d’observation et de tests internes, parmi de nombreuses nouveautés dont la plupart ne s’imposaient pas dans la pratique, nous avons identifié et intégré celle qui apportait une réelle valeur ajoutée : un nouveau modèle pour répondre mieux aux besoins de nos clients.

En l’espace de trois ans, l’IA générative est passée de curiosité à outil utilisé au quotidien. Elle s’est installée dans la sphère privée avant de gagner du terrain dans les entreprises. À vrai dire, ChatGPT est souvent ouvert avant même que le café ne soit tiré…mais derrière cette présence devenue familière, les usages sont étonnamment sobres. Comme le montre l’étude du NBER, cette adoption reste très mesurée : l’IA est surtout utilisée pour reformuler un texte, traduire, résumer, chercher une information ou même demander un conseil.

C’est précisément là que se révèle un contraste avec l’évolution du marché. Alors que les usages se concentrent sur quelques tâches essentielles, l’industrie poursuit une course effrénée à la performance brute, développant des modèles toujours plus grands.

Pourquoi ? Pour feindre l’intelligence humaine, quête totalement utopiste à ce stade, et ce, sans se soucier de leur consommation énergétique et leur coût d’exploitation.

« More is better » n’est pas la solution, comme le rappelle Yann LeCun, les LLM restent limités par nature : ils ne comprennent pas le monde physique, ne disposent pas de mémoire persistante et ne savent ni planifier ni raisonner. Ils n’ont donc pas vocation à devenir des intelligences générales. En revanche ils excellent dans leurs forces fondamentales : analyser, structurer, reformuler et générer du texte.

Cela tombe à point nommé, car ces compétences correspondent précisement à l’usage que les gens en font. Une question essentielle se pose alors : comment évaluer de manière objective la performance d’un modèle sur ces besoins?

Nos critères de sélection

Bien souvent, les utilisateur·ice·s des IA ont une appréciation très subjective de leur capacité. C’est pourquoi les communautés scientifiques (autant académiques qu’industrielles) ont mis en place des critères d’appréciation objectifs et quantitatifs pour comparer les modèles entre eux. Ces critères sont basés sur des scores obtenus à l’aide de « benchmarks » (tests de référence standardisés) visant à mesurer « l’intelligence » et la performance des modèles. Tout nouveau modèle est en général accompagné des scores qu’il a obtenu aux principaux tests du moment.

Malheureusement ces résultats de tests ne reflètent ni la performance réelle ni l’utilisabilité dans les situations concrètes d’industrialisation. En visant avant tout l’optimisation de ces scores, les créateur·ice·s peuvent être amené·e·s à privilégier des ajustements qui, en définitive, nuisent à son efficacité pratique.

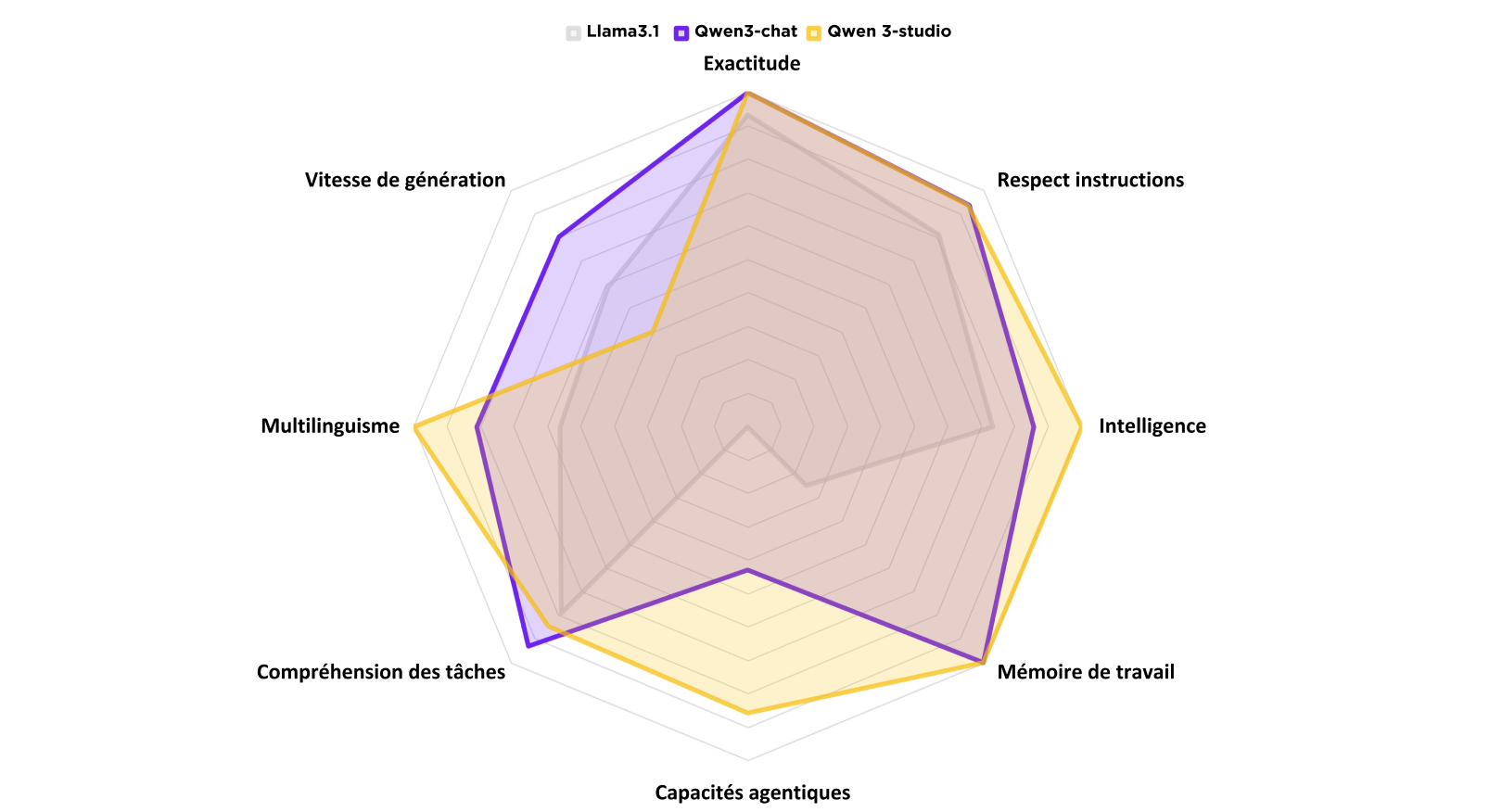

À contrario, notre méthode d’évaluation, ne tient pas uniquement compte de ces benchmarks. Ces derniers viennent compléter nos propres critères déterminants, à savoir :

- Précision et exactitude dans les réponses aux questions.

- Respect strict des instructions fournies.

- Absence d’hallucinations (voir notre article à ce sujet).

- Capacité à ingérer et comprendre de grandes quantités de texte.

- Maîtrise multilingue dans les langues nationales et les langues les plus couramment utilisées.

- Exécution précise et fiable de processus agentiques.

Bien que la notion d’IA « agentique »1 soit encore émergente, nous la retrouvons dans notre benchmark comme critère, car elle apporte de nouvelles opportunités, complétant la simple interaction conversationnelle entre l’utilisateur et l’IA.

Évaluation et nouveau modèle

Sur la base des critères énoncés et de notre ressenti à l’utilisation, nous avons décidé de ne plus baser nos modèles sur Llama 3.1, mais sur la suite open source Qwen 3 et ce, sans sacrifier sécurité, confidentialité et évidemment hébergement exclusif sur le sol Suisse.

Ci-dessous les résultats de notre évaluation :

À noter que parmi les nombreux avantages de cette amélioration technique, c’est surtout l’augmentation significative de la mémoire qui a guidé notre choix. Une mémoire plus large profite directement aux tâches exigeantes et au traitement de documents.

Et Apertus ?

Ce projet, 100 % suisse, représente une initiative importante, notamment par la transparence complète de ses données et du processus d’entraînement. Il a l’ambition de proposer une base pour des modèles performants dans les langues nationales et alignés avec les spécificités culturelles du pays.

Alors qu’est-ce que l’on en a pensé ? Malgré les attentes parfois irréalistes qui ont pu entourer cette première version, nous saluons la mission ainsi que le travail effectué. Nos tests montrent toutefois qu’il n’est pas encore suffisamment compétitif pour une utilisation générale dans nos outils, notamment en raison des limites dans son usage agentique. Cela ne remet pas en question son potentiel et nous gardons un oeil attentif à ses évolutions.

Suivre le rythme des avancées en IA est devenu un veritable défi et c’est précisément pour cela que nous prenons le relais. Notre veille continue nous permet d’identifier, analyser et tester les nouveautés pour nos clients. Cela fait partie intégrante de notre mission : leur fournir les meilleurs outils, au moment où ils sont matures et aboutis.

En travaillant jour après jour avec passion pour devenir le catalyseur d’innovation capable d’étendre votre propre R&D, Deeplink se positionne comme votre partenaire clef. Nous sommes la garantie d’un véritable allié stratégique pour tirer pleinement parti des avancées technologiques sans jamais perdre de vue vos priorités business.

- « L’IA agentique est un système d’intelligence artificielle capable d’atteindre un objectif précis avec une supervision limitée. Il se compose d’agents IA, c’est-à-dire de modèles de machine learning qui imitent les capacités humaines de prise de décision pour résoudre les problèmes en temps réel. Dans un système multi-agent, chaque agent exécute une sous-tâche spécifique pour atteindre l’objectif et leurs efforts sont coordonnés grâce à des fonctionnalités d’orchestration de l’IA. » IBM – Qu’est ce que l’IA agentique? ↩︎